Роботы пугают нас, чувак. Они уже соревнуются с человеком — а что будет лет через сто? Если кто-то говорит, что он не боится роботов, то он или работает с ними, или он сам — андроид. Думаешь, мы сейчас истерим на пустом месте и преувеличиваем? Думаешь, что это всё возможно только в теории и в фантастических романах? Возможно. Тогда как ты примиришься с тем, что мы тебе сейчас расскажем?

1. Робота свели с ума

Исследователи Университета Техаса-Остина сделали это! Они заставили робота заболеть шизофренией! Им удалось перенести умственные заболевания на компьютеры, и благодаря их усилиям суперкомпьютер стал шизофреником. Молодцы они?

Неужели где-то в списке завидных научных достижений значилось «заразить робота шизофренией»? Это не ошибка? Не злая шутка?

Паниковать поздно, потому что DISCERN — это самая что ни на есть реальная вещь. Это нервная сеть: искусственный разум, воспроизводящий нервные соединения в мозгу. Чтобы описать механизм шизофрении, исследователи разработали теорию, согласно которой шизофреники держат в голове слишком много информации. Они знают и умеют вещи, которые им не нужны, и не могут систематизировать информацию.

Ученые сымитировали шизофрению на искусственном интеллекте (не уверены, что печатать такие вещи не преступно), рассказывая ему кучи историй, позволяя ему устанавливать связи между словами и событиями и хранить в памяти только их актуальные детали. И заработало!

Затем они усилили датчик памяти, заставляя его сохранять все детали, важные и неважные, и оп! — робот-шизофреник! Компьютер запутался в том, что ему рассказывали, и не мог рассказать ни одной сколько-нибудь связной истории.

Насколько сильно он сошел с ума?

Сначала он взял на себя ответственность за теракт. Он связно рассказал исследователям, что заложил бомбу. Компьютер сделал это, потому что перепутал рассказ о террористе с собственными «воспоминаниями». Из-за сбоя компьютер начал думать, что она сам был в роли террориста.

И еще один жуткий пример: компьютер начал говорить о себе в третьем лице. Он просто забыл, кто он. У DISCERN развилось неверное самоощущение. Мы надеемся, что ребята всё же разработали какие-то антипсихотические средства: мало ли чем может обернуться такой эксперимент!

2. Робота научили врать

Ученые научили группу роботов нескольким концепциям обмана, так что самое время кричать: «Роботы научились врать!» Вот как было дело.

Эти стратегии были смоделированы по образцам поведения птиц и белок (потому что белки, вероятно, самые хитрые засранцы животном мире), а потом продемонстрированы профессором Рональдом Аркином из Технологической школы интерактивных компьютеров Джорджии: он отправил робота в укрытие, а следом — второго робота, чтобы он нашел первого.

Это работало следующим образом. Роботы должны были продвигаться по пути с препятствиями, которые они сбивали во время прохождения трассы. После первого бота, проследовавшего таким путем, по его следам шел второй, который должен был найти его по опрокинутым предметам. Прятавшийся робот научился переворачивать предметы, чтобы направлять второго робота по ложному следу, а потом прятался подальше от этого беспорядка. Это простая тактика, благодаря которой в 75% случаев второй робот не мог найти первого.

Программа не была внесена в робота с самого начала. Роботов обучали ей, и они сами постигали ее путем проб и ошибок. Это всего лишь университетский эксперимент, так? Представь, если он выльется во что-то более серьезное и будет использоваться, например, военными… Погоди, а ведь так оно и есть! Эксперимент проплачен американскими военными. Так что берегись: роботы вооружены и очень опасны! Это же реально угроза для человечества!

Хотя, может, нам не стоит бояться? Роботы запрограммированы так, что для лжи им нужны определенные условия: они должны быть вовлечены в конфликт и иметь личную выгоду от обмана.

3. Роботов научили быть беспощадными

Сотрудники Лаборатории интеллектуальных систем взяли группу роботов, так называемые «источник пищи» и «источник яда» — и поместили их в одну комнату. Молодцы. Возможно, идея отравить робота немного странная, но цели-то у ребят благие, они явно пойдут на пользу для дальнейшего выживания человечества. Как ты и сам можешь предсказать, чувак, ни один робот не умер. Зато они поняли, что милосердие — это глупость.

Роботы получали очки за нахождение вблизи источников пищи и теряли очки, когда находились рядом с ядом. К ним были приделаны небольшие синие огоньки, которые загорались в случайное время (хотя роботы могли контролировать этот процесс, если хотели, запомни этот момент), и камера, воспринимавшая эти вспышки света. Когда испытания начались, роботам не потребовалось много времени, чтобы понять, что скопление синих огоньков — это другие роботы, а значит, рядом с ними находится источник пищи. Поскольку лампочки роботов мигали, они показывали остальным товарищам, где была пища, и помогали им зарабатывать очки.

После нескольких испытаний большинство роботов прекратили мигать лампочками. Почти все. Роботам дали задание, и они отказались помогать друг другу. Возможно, это и хорошо для человечества, кто знает. Есть и еще одна пугающая деталь: некоторые роботы включали лампочку, находясь вблизи источника яда, и так пытались подставить своих товарищей.

4. Роботам дали воображение

Один из проектов Гугла, которые однажды, определенно, приведут к падению человеческой цивилизации. Помнишь робота-шизофреника? Это похожий парень, но только он не сошел с ума, он просто жутко чувствительный. Суперкомпьютер Гугла подключили к Интернету и позволили ему сохранять всё, что он захочет. Его не программировали, не давали ему инструкций. У этого суперкомпьютера была возможность сохранить все богатства человеческой истории, а он предпочел… смотреть на картиночки с котами! Вот это он слюнтяй.

Оказалось, что все используют Интернет одинаково — и хрупкие конструкции из костей и мяса, и адские супермашины. Оставьте нас в покое, мы все любим кис. Потом Гугл обнаружил, что компьютер даже разработал свою собственную концепцию относительно того, как выглядит кошка, и он представил себе абсолютно нового кота, основываясь на тех картинках, что он видел раньше. Вот что у него вышло:

Кстати, похоже на кота! Молодец, компьютер!

А вот так он представляет себе людей:

Жуткий безглазый тип. Но он похож на человека.

5. Робота научили предсказывать будущее

Еще один суперкомпьютер называется «Наутилус». В его память поместили миллионы новостей начиная с 1945 года и попросили его выбрать две вещи: место и настроения. Используя огромное количество информации о событиях прошлого, он смог сделать прогнозы относительно того, что произойдет «в будущем». И прогнозы его были весьма точными.

Насколько точными? Например, он нашел Бен Ладена. Разумеется, уже после того, как его нашли по-настоящему. Конечно, разъяренный компьютер не врывался в его квартиру, но смог определить его местоположение. Америке и ее союзникам потребовалось 11 лет, две войны, два президента и миллиарды долларов, чтобы обнаружить террориста.

Все, кто искал Бен Ладена, думали, что он в Афганистане. «Наутилусу» потребовалось гораздо меньше времени, и, просто промониторив все новостные сводки, упоминавшие Бен Ладена и его предполагаемое местонахождение, «Наутилус» сузил район поисков до 200-километровой площади в Северном Пакистане. Она включала в себя и Абботтабад, где по правде находился Бен Ладен.

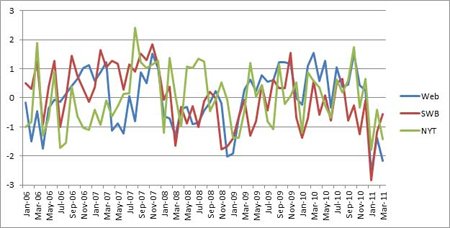

Тебе мало? Еще «Наутилус» смог предсказать Арабскую весну. Он мониторил актуальные новости и оценивал падение общественных настроений, подсчитывая количество слов с позитивной и негативной коннотацией. У нас даже есть график.

Так что роботы немного умеют предсказывать будущее. Они наверняка даже предскажут исчезновение человечества, особенно когда им приделают конечности. Но пока это работает только для того будущего, которое уже осуществилось: «Наутилусу» дают информацию о прошлом и смотрят, насколько точно он угадывает, что уже произошло. Однако ученые подумывают и о том, чтобы научить его предсказывать будущее по-настоящему.

А еще ты удивишься, когда узнаешь, что полиция Балтимора использует компьютеры, чтобы предсказать убийство — прямо как в фильме «Особое мнение». Может, алгоритм и несовершенен: он учитывает разные факторы, например, первое преступление, природу преступления, частотность преступлений — и на их основе определяет, насколько велика вероятность, что человек убьет или будет убит. Ужас-то какой!

Комментарии

(0)